Meta研究人员提出了MCC,这是一种可以基于单个图像重建3D模型的方法,从中,Meta看到了VR/AR和机器人技术的应用前景。

目前,依赖于Transformers等架构和大量训练数据的AI模型已经产生了令人印象深刻的语言模型,例如OpenAI GPT-3或最近的ChatGPT。

自然语言处理的突破带来了一个关键的见解:基础模型扩展将成为可能,而先决条件是领域独立的架构,例如可以处理不同模式的转换器,以及使用大量未标记数据进行自我监督训练。

这些架构与大规模、类别无关的学习相结合,已应用于语言处理以外的领域,例如图像合成或图像识别。

Meta MCC为3D重建带来规模化处理

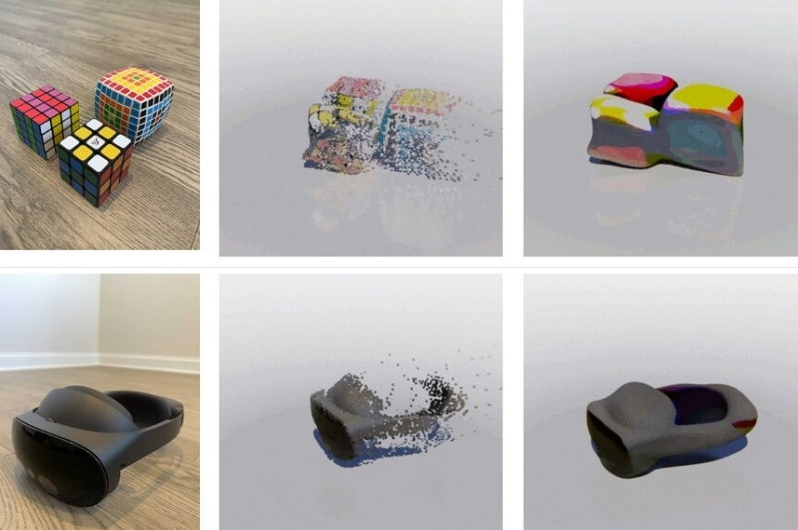

Meta FAIR Lab演示了多视图压缩编码 (MCC),这是一种基于变换器的编码器-解码器模型,可以基于单个RGB-D图像重建3D对象。

研究人员认为MCC是迈向用于机器人或AR/VR应用的3D重建通用AI模型的重要一步,基于这些模型,为更好理解3D空间和对象或视觉重建开辟了无数可能性。

由于带有深度传感器的iPhone和从RGB图像中获取深度信息的简单AI网络的普及,此类具有深度信息的图像现在很容易获得。Met表示,该方案易于扩展,并且将来可以轻松生成大型数据集。

而为了展示该方案的优势,研究人员正在采用不同数据集的深度信息图像和视频来训练MCC,以从多个角度显示物体或整个场景。

在训练期间,模型被剥夺了用作学习信号的每个场景或对象的一些可用视图。该方法类似于语言或图像模型的训练,其中部分数据通常也被屏蔽。

Meta 3D重建表现出很强的普适性

Meta AI模型在测试中显示出了有效且优于其他方案的优势,团队还表示,MCC可以处理以往从未见过的对象类别或整个场景。

此外,MCC显示出预期的缩放特性:随着更多的训练数据和更多样化的对象类别,性能显著提高。iPhone镜头、ImageNet和DALL-E 2图像也可以重建为具有适当深度信息的3D点云。

我们提出MCC,一种适用于对象和场景的通用3D重建模型,我们还展示了对具有挑战性的设置的概括,包括野外捕获和AI生成的想象物体图像。

我们的结果表明,一种简单的基于点的方法与类别不可知的大规模训练相结合是有效的。我们希望这是朝着构建用于3D理解的通用视觉系统迈出的一步。

来源:93913

投稿:tougao@arinchina.com

稿件/商务合作: Vicky(微信 ARC-vicky)电话:18700987744

创始人:张明军(微信 13720775110)

更多精彩内容,请关注ARinChina微信公众号(ID:X增强现实)

评论