受限于手部遮挡和手部移动复杂方式,目前机器理解手部与物体的交互仍然是一个挑战。

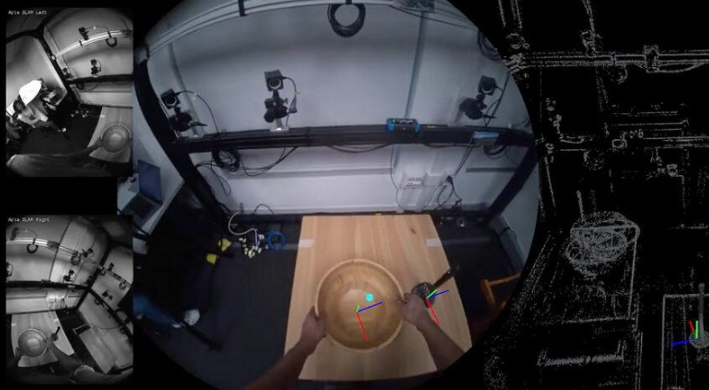

为此,Meta Reality Labs研究人员发布了一个名为HOT3D(“手和物体跟踪”缩写)的数据集,旨在帮助研究人员开发基于视觉的系统,以更好理解手与物体的交互,从而集成于新的应用。

“例如,这样的系统将能够实现用户之间的手动技能转移,首先捕捉专家用户执行一系列手部与物体交互的动作(组装家具、发网球等),然后使用捕获的信息指导经验不足的用户,例如通过AR眼镜, ”研究人员在论文中写道。“这些技能也可以从人类转移到机器人身上,使自主机器人能够即时学习。该系统还可以帮助人工智能助手更好理解用户行为,或为 AR/VR用户提供新的输入功能,例如,将任何物理表面变成虚拟键盘,或将铅笔变成多功能手柄。”

该数据集包含超过800分钟的以自我为中心的视频记录,展示了与33种日常物品的互动。除了拿起、看和放下物品的简单场景,该数据集还包括厨房、办公室和客厅环境中的典型动作。

在此系统组成部分,两款Meta设备用于捕获视频数据:Project Aria眼镜和Quest 3。由于 Meta使用这些设备,因此数据集可能主要用于训练Meta现有和未来的AI/AR/VR眼镜和头显AI系统。

来源:93913

稿件/商务合作: 向前(微信 Shixiangqian7)电话:18700987744

创始人:张明军(微信 13720775110)

更多精彩内容,请关注ARinChina微信公众号(ID:X增强现实)

我的微信

这是我的微信扫一扫

评论