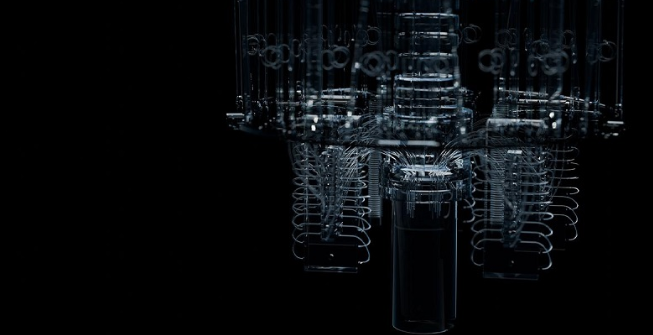

NVIDIA宣布与Google Quantum AI合作,基于NVIDIA CUDA-Q™平台模拟以加速其下一代量子计算设备的设计。

Google Quantum AI正在使用混合量子-经典计算平台和NVIDIA Eos超级计算机来模拟其量子处理器的物理特性。这将有助于克服量子计算硬件目前的局限性,由于“噪音”,量子计算硬件只能运行一定数量的量子运算,然后计算必须停止。

Google Quantum AI研究科学家Guifre Vidal表示:“只有我们能够在控制噪声的同时扩大量子硬件的规模,才有可能开发出具有商业用途的量子计算机。基于NVIDIA加速计算,我们正在探索越来越大的量子芯片设计对噪声的影响。”

要理解量子硬件设计中的噪声,则需要复杂的动态模拟,才能够完全捕捉量子处理器中的量子位如何与其环境相互作用。

传统上,这些模拟的计算成本过高。然而,通过CUDA-Q平台,谷歌可在NVIDIA Eos超级计算机上使用1024个NVIDIA H100 Tensor Core GPU,以极低的成本执行世界上最大、最快的量子设备动态模拟之一。

NVIDIA量子和HPC总监Tim Costa表示:“AI超级计算力将有助于量子计算的成功。谷歌对CUDA-Q平台的使用证明了GPU加速模拟在推进量子计算以帮助解决现实问题方面发挥的核心作用。”

借助CUDA-Q和H100 GPU,谷歌可对包含40个量子比特的设备进行全面、逼真的模拟,这是此类模拟中规模最大的。CUDA-Q提供的模拟技术意味着原本需要一周时间才能完成的嘈杂模拟现在可以在几分钟内完成。

支持这些加速动态模拟的软件将在CUDA-Q平台上公开提供,从而支持量子硬件工程师快速扩展系统设计。

来源:93913

稿件/商务合作: 向前(微信 Shixiangqian7)电话:18700987744

创始人:张明军(微信 13720775110)

更多精彩内容,请关注ARinChina微信公众号(ID:X增强现实)

评论